Le système d’information d’une entreprise regorge de nombreuses applications .

Cela va des simples applications utilisateurs comme les traitements de texte aux logiciels d’administration du parc informatique comme les logiciels de supervision .

Pour les utilisateurs, on trouve des suites bureautiques avec traitement de textes, tableur, présentation, logiciel de dessin :

– Gratuit : Open office, Star Office, Koffice

– Payant : Corel Word Perfect, Microsoft Office

En particulier, les logiciels de traitement de texte sont souvent utilisés :

Microsoft Word, Open Office, Star Office (SUN), LateX (gratuit, sous Linux)

Toujours pour les utilisateurs, on trouve les logiciels ERP (Enterprise Ressource Planning) comme Microsoft Outlook / Microsoft Exchange, Lotus Notes / Lotus Domino ou Calendar de Mozilla .

On trouve aussi les logiciels de CRM (Customer RelationShip Management, gestion de la relation client) .

Pour les développeurs, on trouve les EDI (Environnement de Développement Intégré) comme Microsoft Visual Studio .NET, ou encore Eclipse (qui est Open Source et gratuit) voir NetBeans pour le Java .

Pour le développement Web, on trouve des logiciels CMS Content Management System (ou WCM Web Content Management) comme les services de publication internet comme PHPNuke ou SPIP (sous Linux, Open Source) .

Les navigateurs les plus courants sont Microsoft Internet Explorer MIE v6, Mozilla Firefox, Netscape, Konqueror (sous KDE Linux), Opéra et Safari d’Apple . NCSA Mosaic et Lynx ont disparu depuis longtemps .

On trouve aussi des outils pour réaliser des modélisations UML comme Rational Rose, Borland Together (payants) ou ArgoUML pour le java (Freeware) .

Pour faire cohabiter les différentes applications du parc informatique, il existe deux approches, l’approche des WebServices qui est normalisée ou l’approche habituelle EAI (Enterprise Application Integration) .

Il s’agit de faire cohabiter les applications et de centraliser les données sur une base unique en adaptant les formats d’enregistrement des données entre elles .

Les bases de données habituellement rencontrées sont :

– MySQL ou PostgreSQL: des serveur SGBD Open Source pour de petites bases : autour de 30 000 entrées .

(PostgreSQL est plus sécurisé que MySQL .)

– Oracle 8i, qui est adapté pour des volumes de données bien plus élevées .

– MSSQL (Microsoft SQL Server) ou MSDE (= petit Microsoft SQL Server de développement gratuit)

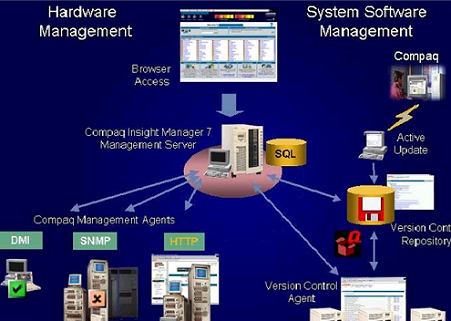

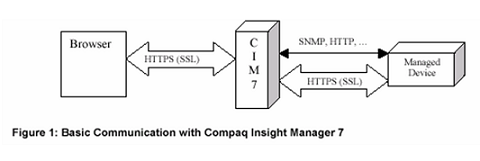

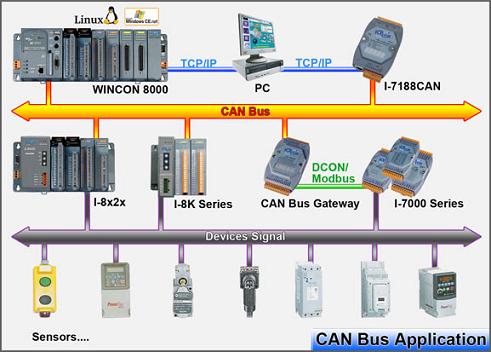

Pour l’administration réseau, on trouve comme logiciels de supervision réseau et de monitoring :

Websense, Tivoli, Observer, Unicenterde Computer Associates (CA), HP Openview HP-OV, Ciscoworks, BMC Patrol (Patrol DashBoard), What’s Up de Ipswitch, Snmpc aussi, Loriot Pro de Luteus et Observer de Network Instruments, sans oublier Compaq Insight Manager SP7 (pour les SAN notamment); MOM de Microsoft, Synexsys, Patrol Visualis mais aussi NSM de Computer Associates, FLUKE ou Nagios (sous Linux et libre) .

Nagios est un très bon produit et pour vous faciliter la vie, il existe une solution Open Source Oreon qui propose un frontend à Nagios .

On trouve aussi Zabbix qui est une bonne alternative à Nagios . Hp OpenView est sûrement une des solutions les plus adéquates mais payante et difficile à prendre en main : Cette application reconnaît toutes les MIB réseau ainsi que les MIB type onduleur et bien d’autre encore …

Cependant, il faut utiliser des produits complémentaires pour pouvoir tout superviser :

– pour toutes les options de surveillance pour les produits Cisco, Cisco view

– optivity pour nortel, alcatel

– cabletron pour cabletron etc ….

La prise en main nécessite une bonne formation pour l’installation et la gestion .

En fait, souvent, une entreprise dispose de plusieurs outils de monitoring .

Par exemple, l’ensemble des outils suivants : nagios, cacti, hp openview, what’s up, ntop, hp sim, mrtg, rdd tool, smokeping .

Cela lui permet de couvrir toutes les informations qu’elle recherche .

Pour étudier le trafic sur notre réseau (ex : y a t’il un trafic VoIP, P2P ?), on dispose aussi de sondes réseaux ou sniffers .

Exemples : Etherreal (sous Linux ou Windows), TCPDUMP sous Linux (=WINDUMP, WINPCAP sous Windows), SNORT (qui est aussi un IDS)

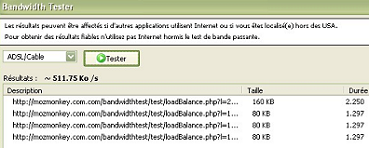

Pour la gestion du trafic applicatif et de la bande passante sur les liens WAN, il existe des serveurs comme PacketShaper de Packeteer …

PacketShaper sauvegarde les performances des applications suivant les priorités de l’entreprise, grâce à la surveillance, au contrôle et à la compression du trafic sur les liens d’accès WAN et Internet susceptibles d’être congestionnés .

Pour la surveillance des activités des salariés, le dépannage et l’assistance à distance des cellules de maintenance technique, ou pour suivre un cours dans une salle informatique en déportant son écran sur tous les ordinateurs de la salle, il existe des télécommandes d’ordinateurs comme Timbuktu Pro, Symantec PcAnyWhere 11.5 ou encore l’assistance à distance intégré dans XP voir le bureau à distance si on dispose d’un serveur Terminal Server de client léger.

On trouve aussi Microsoft SMS Server 2003 (= System Management Server) qui est un système d’administration de parcs informatique et réseaux de Microsoft (Je l’ai utilisé dans l’entreprise VAI CLECIM) . Il permet la prise de contrôle à distance via Terminal Server .

Enfin, il existe VNC de la société AT&T qui est gratuit, Open Source sous licence GNU/GPL et que j’ai également eu l’occasion de déployer .

Tous ont une approche client-serveur . Une machine dite cliente prend le contrôle d’une machine distante appelée serveur .

Concrètement, l’écran de la machine serveur apparaît dans une fenêtre de la machine cliente et, à partir de celle-ci, l’utilisateur peut effectuer toute opération ou commande pour piloter la machine serveur exactement comme s’il était physiquement au pupitre de cette machine .

Une même machine peut jouer à la fois le rôle de serveur et celui de client .

Plusieurs clients peuvent se connecter en même temps sur un même serveur VNC .

VNC fonctionne avec le protocole de communication réseau TCP/IP et se base sur le protocole Remote Frame Buffer (RFB) pour l’affichage graphique . L’encodage utilisé transmet la première image puis uniquement les pixels qui ont changé . Si l’image change beaucoup, alors la bande passante utilisée augmente sensiblement (une vidéo en plein écran par exemple) .

– RealVNC – La version officielle disponible sur les OS Windows, Linux, Solaris et HP-UX .

– ViNCe – Client VNC pour RISC OS

– OSXvnc – Serveur Macintosh

– Chicken of the VNC – Client Macintosh

– VNC Scan Enterprise Console – VNC Manager pour installer VNC sur des ordinateurs distants

Au niveau de la sécurité, on peut réaliser une audit de sécurité sur un réseau avec NESSUS ou de façon plus élémentaire sur les petits réseaux Microsoft avec l’outil gratuit MBSA Microsoft Baseline Security Analyser v2.0 .

Pour le pare feu logiciel, on trouve :

ZoneAlarm Professionnel, Zone Alarm (XP, gratuit), Norton Personal Firewall (Symantec), OutPost (gratuit pour usage non commercial) .

On trouve aussi des pare feu professionnel chez des grossistes spécialisés sécurité comma Allasso ou RISC Technology .

Pour détecter les spywares, il existe en version gratuite :

SpyBot Search and Destroy, Microsoft Windows Defender = Microsoft Antispyware (ancien nom), Ad-Aware

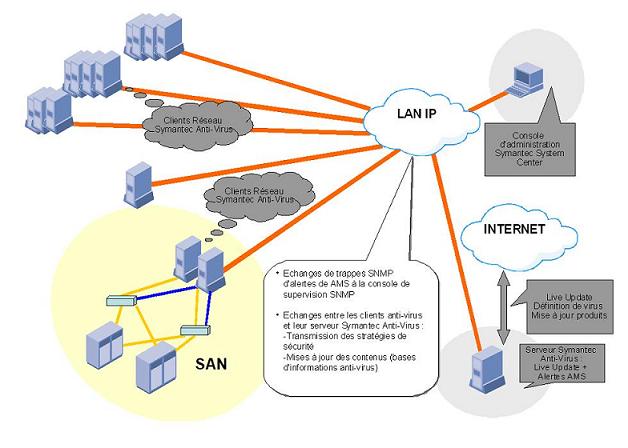

Pour les anti-virus, on trouve :

– Sophos: anti-virus sous Linux ou Windows (payant) (=leader des antivirus d’entreprises en terme de performances)

– McAfee Antivirus

– AVG Control Center de Grisoft

– Norton Internet Security et Norton Anti-virus de Symantec (1 inconvénient : une charge mémoire élevée)

– Kaspersky Anti-virus

– Antivir Personal Edition

– MSRT Malicious Software Removal Tool : l’outil de suppression des logiciels malveillant de Microsoft

Pour compléter la protection Pare-Feu / Anti-virus, il peut être utile d’ajouter un détecteur d’intrusion (NIDS = Network Intrusion Detection System) .

C’est un programme qui suit le trafic de votre réseau à la recherche de tentatives d’intrusions . Il peut prévenir l’administrateur du système dès qu’une telle intrusion a lieu. On peut ou pas le coupler à un mur pare-feu . Les réponses peuvent consigner le détail des attaques, mettre fin à la connexion et reconfigurer le pare-feu pour se préserver d’attaques ultérieures. Il est complémentaire à un anti-virus et à un pare-feu et ne nécessite pas de mise à jour de signatures. Il identifie les intrusions d’un point de vue technique . Il étudie les flux autorisés par le firewall et contrôle qu’ils n’ont pas de comportements suspects . Il vérifie que les applications autorisées par le pare feu se comportent comme attendu et, par exemple, ne vont pas examiner le contenu de dossiers confidentiels .

On trouve notamment :

–GesWall (sous Windows) : cumule les fonctions de firewall et antispyware (pré-configuré)

-PrevXHome (gratuit pour les particuliers)

–SNORT : C’est l’IDS le plus déployé et utilisé et il est disponible sous Linux / Unix mais également Windows comme freeware Open Source . Il peut aussi être utilisé comme sonde .

Les ports des services généralement rencontrés sur les machines d’un parc informatique sont :

7 echo; 21 et 20 ftp File Transfer Protocol; 22 ssh Secure Shell; 23 telnet; 25 SMTP; 70 GOPHER; 79 FINGER; 80 HTTP; 110 POP3 Post Office Protocol – Version 3; 119 NNTP Network News Transfer Protocol; 137 et 138 et 139 NETBIOS-NS NETBIOS Name Service; 143 IMAP 4, IMAP 2 Interim Mail Access Protocol v2; 161 et 162 SNMP Simple Network Managment Protocol; 179 BGP Protocole de routage Border Gateway Protocol; 194 IRC Internet Relay Chat; 443 HTTPS; 517 TALK (commande talk Linux); 1521 Serveur SGBD Oracle; 3306 Mysql Server; 8080 HTTP Alternatif

et son magasin en ligne . C’est peut être techniquement le meilleur format même si il est bien moins utilisé que le MP3 standard . Contrairement au MP3 ou WMA, la compression s’appuie non pas sur le MPEG-1 mais sur le MPEG-4 (du DivX ) . La qualité CD s’obtient avec un débit de 96 Kbps, il existe un système de DRM et il gère le son sur 48 canaux (donc compatible avec le Dolby Digital 5.1 des DVDs). L’excellence !

et son magasin en ligne . C’est peut être techniquement le meilleur format même si il est bien moins utilisé que le MP3 standard . Contrairement au MP3 ou WMA, la compression s’appuie non pas sur le MPEG-1 mais sur le MPEG-4 (du DivX ) . La qualité CD s’obtient avec un débit de 96 Kbps, il existe un système de DRM et il gère le son sur 48 canaux (donc compatible avec le Dolby Digital 5.1 des DVDs). L’excellence !